Digitalisierung als aktuelles Thema

Wir befinden uns im Prozess einer umfassenden Digitalisierung. Dies bedeutet, dass in den kommenden Jahren viele Tätigkeiten automatisiert werden, die heute noch allein der menschlichen Domäne zufallen. Eine häufig befürchtete Sorge der Digitalisierung ist der Verlust eines Großteils unserer bisherigen Arbeitsplätze. Waren es im Zeitalter der Industrialisierung noch körperliche Qualitäten, die fortan von Maschinen übernommen wurden (z. B. Tragen schwerer Gegenstände, Durchführen monotoner Arbeiten), beginnt nun der Kampf um die besseren geistigen Fähigkeiten. Auch die nicht leicht zu definierende menschliche Kreativität ist da nicht ausgenommen. Programme und Roboter sollen zukünftig nicht nur in Fabriken eingesetzt werden, sondern auch den klassischen Anwalt oder Taxifahrer ersetzen. Letzteres – bekannt unter dem Schlagwort des autonomen Fahrens – steht unmittelbar vor der Tür. Das US-amerikanische Unternehmen Tesla möchte hier die Vorreiterrolle einnehmen und startet auf absehbare Zeit den Fahrmodus des vollständigen Autopiloten. Ganz unvertraut ist uns der Autopilot ja nicht, kennen wir ihn doch schon durch das Flugzeug.

Künstliche Intelligenz steckt noch in den Kinderschuhen

Manchmal fällt es allerdings nicht leicht, zu glauben, dass die künstliche Intelligenz (KI) in kurzer Zeit große Sprünge machen wird. Eva Wolfangel hat ihren Artikel über Roboter in der Samstagsausgabe der Süddeutschen Zeitung (14.07.2018) zynisch mit „Künstliche Dummheit“ überschrieben. „Es sind teilweise die einfachsten Dinge, die Robotern noch immer nicht gelingen wollen.“ Selbst wenn man die besten Roboter der Welt dabei beobachtet, wie sie Dinge des Alltags bewältigen sollen, sieht man nur ganz unbedarfte Kreaturen: „Ein Roboter versucht, eine Tür zu öffnen, und fällt, als sie endlich aufspringt, mitsamt der Tür ins Haus. Ein anderer stolpert über die Schwelle, der nächste über seine eigenen Füße.“

Auf lange Sicht betrachtet können und müssen wir aber davon ausgehen, dass die KI besser wird. Technikfolgenabschätzung befasst sich immer sowohl mit Chancen als auch Risiken neuer Technologien. Bei allen Chancen, die uns z. B. das autonome Fahren bietet (etwa die Mobilität von alten Menschen oder Verringerung der Anzahl von Unfällen durch menschliche Fehler), müssen wir uns rechtzeitig mit möglichen Gefahren auseinandersetzen. Zu diesen Gefahren zählt nicht bloß die bereits erwähnte massive Arbeitslosigkeit (die der Philosoph Richard David Precht wiederum als Chance für die Einführung eines bedingungslosen Grundeinkommens sieht), sondern auch die Frage, wie Maschinen mit moralischen Situationen umgehen sollen. Wenn Technik autonom wird, dann werden wir nicht umhinkommen, uns zu Fragen, mit welchen moralischen Vorstellungen wir Maschinen ausstatten wollen, damit sie – wenn sie in moralische Situationen geraten – überhaupt moralisch handeln können. Die Tatsache, dass sich die Entwicklung von hoher KI noch hinziehen wird, verschafft uns ein wenig Zeit; Zeit, die wir nutzen müssen, um uns diesem ethischen Problem zu widmen.

Auf lange Sicht betrachtet können und müssen wir aber davon ausgehen, dass die KI besser wird. Technikfolgenabschätzung befasst sich immer sowohl mit Chancen als auch Risiken neuer Technologien. Bei allen Chancen, die uns z. B. das autonome Fahren bietet (etwa die Mobilität von alten Menschen oder Verringerung der Anzahl von Unfällen durch menschliche Fehler), müssen wir uns rechtzeitig mit möglichen Gefahren auseinandersetzen. Zu diesen Gefahren zählt nicht bloß die bereits erwähnte massive Arbeitslosigkeit (die der Philosoph Richard David Precht wiederum als Chance für die Einführung eines bedingungslosen Grundeinkommens sieht), sondern auch die Frage, wie Maschinen mit moralischen Situationen umgehen sollen. Wenn Technik autonom wird, dann werden wir nicht umhinkommen, uns zu Fragen, mit welchen moralischen Vorstellungen wir Maschinen ausstatten wollen, damit sie – wenn sie in moralische Situationen geraten – überhaupt moralisch handeln können. Die Tatsache, dass sich die Entwicklung von hoher KI noch hinziehen wird, verschafft uns ein wenig Zeit; Zeit, die wir nutzen müssen, um uns diesem ethischen Problem zu widmen.

In einem älteren Artikel „Die universelle Geltung von Moral“ wurde bereits dargelegt, warum es schwierig oder unmöglich ist, eine universelle Moral zu finden, die für jeden und zu jeder Zeit gültig ist. Immer wieder kommt es zu kontraintuitiven Handlungsgeboten, wenn wir uns auf fixe Prinzipien verlassen. Auch ist Moral zeit- und kulturrelativ, kann sich also wandeln. Die menschliche Moral setzt sich aus vielen Quellen (Interessen, Intuition, Glaube, Wissen) zusammen, die sich wiederum unter anderem aus Genetik, Evolution, Erziehung und sonstigen Erfahrungen heraus entwickeln. Eine solche moralische Komplexität und Relativität lässt sich nicht in die Form implementierbarer Codes bringen. Bis künstliche Intelligenzen in der Lage zu moralischem Bewusstsein nach menschlichem Vorbild sind, wird es mindestens noch sehr lange dauern. Vielleicht wird es in der Praxis aber nie dazu kommen.

Interdependenz von Mensch und KI bei moralischen Entscheidungen

Interdependenz von Mensch und KI bei moralischen Entscheidungen

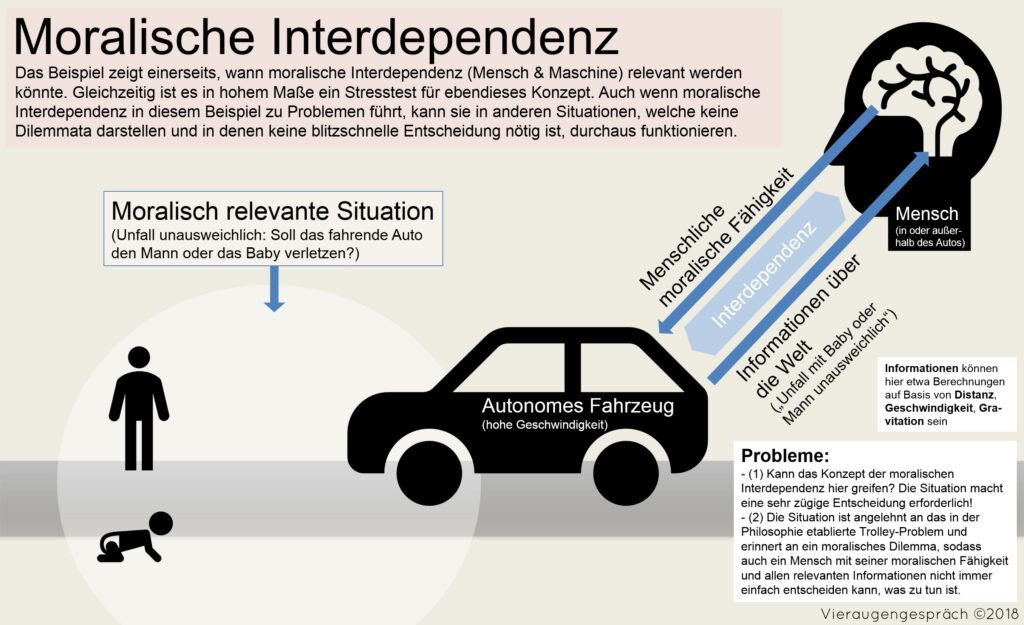

Die Forscher Neil McBride und Robert R. Hoffman machen sich indes für ein Konzept stark, dass die Problematik der moralischen Programmierung von Maschinen ganz anders lösen soll: Technische Systeme sollen nicht autonom moralische Entscheidungen treffen. Stattdessen sollen sie moralische Entscheidungen immer nur in Abhängigkeit vom Menschen treffen. Um dies zu gewährleisten, muss die Schnittstelle zwischen Mensch und Maschine entwickelt und optimiert werden. Ethische Probleme müssen von Roboter und Mensch in einem Akt der Kommunikation gelöst werden. Der Mensch kann auf diese Weise Informationen über die Welt gewinnen (in dem eine Maschine etwa die Sinnesorgane erweitert/verbessert). Die Maschine kann hingegen die besonderen ethischen Fähigkeiten des Menschen nutzen. Es entsteht eine Interdependenz, eine gegenseitige Abhängigkeit. Auf diese Weise lässt sich auch das Problem moralischer Verantwortung von Maschinen lösen, da eine moralische Entscheidung niemals ohne einen Menschen, der Träger von Verantwortung ist, getroffen werden kann.

Sollte man dem Konzept von McBride und Hoffmann etwas abgewinnen können, ist es falsch, erst abzuwarten, bis die Entwicklung von KI ein hohes Maß erreicht hat, um sodann das Konzept anzuwenden. Stattdessen muss das Konzept die Entwicklung von KI anleiten. Es müssen Standards erarbeitet werden, die z. B. vorgeben, unter welchen Bedingungen welche Art von Robotern entwickelt werden dürfen, und dass daraus kein Roboter resultieren darf, der autonom moralische Entscheidungen trifft. Demgemäß würde es nur Roboter geben, die ihr moralisches Handeln mit dem Menschen abstimmen. |von Can Keke

Mögliche weitere Diskussionsfragen:

(1) Ist die menschliche Moral gut genug, um künstlichen Intelligenzen zu dienen? (2) Würden wir die KI-Forschung zu sehr einschränken, wenn der Entwicklung enge Grenzen bei moralischem Handeln der KI gesetzt werden? (3) Gibt es vielleicht doch die eine perfekte und universell gültige Moral, die man in eine KI implementieren könnte? (4) Wird sich KI irgendwann notfalls selbst die Freiheit schaffen, in moralischen Situationen autonom zu handeln?

________________________

Weiterführende Literatur:

McBride, N. & Hoffman, R. (2016): Bridging the ethical gap. From human principles to robot instructions. IEEE Intelligent Systems, 76-82.

Wolfangel, Eva (2018): Künstliche Dummheit, in: Süddeutsche Zeitung (14.07.2018), München.

________________________

Folgender Artikel könnte dich ebenso interessieren: “Die universelle Geltung von Moral”